「人工智能网络并没有试图直接模仿大脑,然而最终看起来像大脑一样,这在某种意义上表明,人工智能和自然之间发生了某种趋同演化。」

计算机擅长理解结构化数据,让计算机去理解主要以文化习惯沉淀下来的人类语言是一件困难的事。不过在 AI 的重要方向,自然语言处理(NLP)领域中,人们经过多年的实践找到了一些方法。

在目前流行的 NLP 方法中,其中一种语言模型就是根据上下文去预测下一个词是什么。通过这种方法,语言模型能够从无限制的大规模单语语料中学习到丰富的语义知识。而预训练的思想让模型的参数不再是随机初始化,而是先有一个任务进行训练得到一套模型参数,然后用这套参数对模型进行初始化,再进行训练。

计算机科学家们一直在通过这种方式试图让电脑尽量接近人类识别语言的水准,却不曾想到有一天会发现它和生物的思考方式异曲同工。

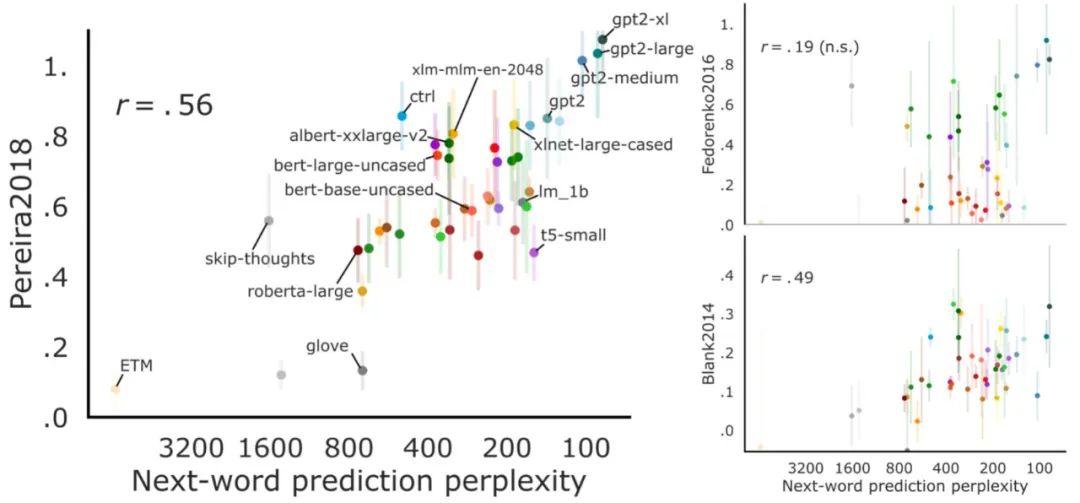

来自麻省理工学院(MIT)的科学家向 AI 模型输入与测试人类大脑相同的刺激,结果发现很多模型获得了与人类相同类型的激活。在超过 40 种语言模型的测试中(包括词嵌入、循环神经网络、Transformer 等),OpenAI 的 GPT 系列可以几乎完美地进行一些推断,而且这种能力具有跨数据集的稳健性。

模型预测出的下一个词越准,它和人类大脑契合度就越高

在过去的几年中,自然语言处理模型在很多任务中都表现出了出色的性能。最值得注意的是,它们非常擅长预测一串文本中的下一个词。这一技术最直白的应用就是在搜索引擎以及很多文本类 APP 上,可以准确地预测出你想要输入的下一个词。

最新一代的预测语言模型似乎也学习了一些关于语言潜在含义的东西。这些模型不仅能预测下一个词,还能执行一些需要一定程度的真正理解才能执行的任务,如问答、文本摘要、故事续写等。这类模型是为了优化预测文本的特定功能而设计的,而不是试图模仿人类大脑如何执行这项任务或理解语言。

但是,来自 MIT 的一项新研究表明,这些模型的基本功能其实类似于人类大脑语言处理中心的功能。

此外,研究人员还发现,在其他类型的语言任务中表现良好的计算机模型并没有展现出此类相似性。这意味着,人类大脑可能会用「下一个词预测」来驱动语言处理。

「模型预测出的下一个词越准,它和人类大脑契合度就越高,」MIT 的认知神经科学教授 Nancy Kanwisher(论文作者之一)表示,「令人惊奇的是,这些模型契合得竟如此之好。这是强烈的间接证据,证明人类的语言系统可能就是在预测接下来会发生什么。」

这项研究发表在最新一期的《美国国家科学院院刊(Proceedings of the National Academy of Sciences)》上。

论文:https://www.pnas.org/content/118/45/e2105646118

论文预印版(Biorxiv):https://www.biorxiv.org/content/biorxiv/early/2020/10/09/2020.06.26.174482.full.pdf

GitHub:https://github.com/mschrimpf/neural-nlp

论文一作 Martin Schrimpf 以及另一位作者 Evelina Fedorenko 在一个视频中针对该论文进行了解读。

论文第一作者,MIT 在读博士 Martin Schrimpf。

当前高性能的下一个词预测模型属于深度神经网络模型。这些网络包含构成不同强度连接的计算「节点」,以及以规定方式在彼此之间传递信息的层。

十多年来,科学家们使用深度神经网络来创建可以识别物体的视觉模型,以实现灵长类大脑的功能。MIT

在这份新研究中,MIT 的研究团队使用类似的方法将人脑中的语言处理中心与语言处理模型进行比较。他们分析了 43 种不同的语言模型,包括一些针对下一个词预测任务进行了优化的模型。这些模型旨在执行不同的语言任务,其中 GPT-3 可以根据提示生成类似于人类生成的文本,还有一些模型旨在补全文本中的空白。

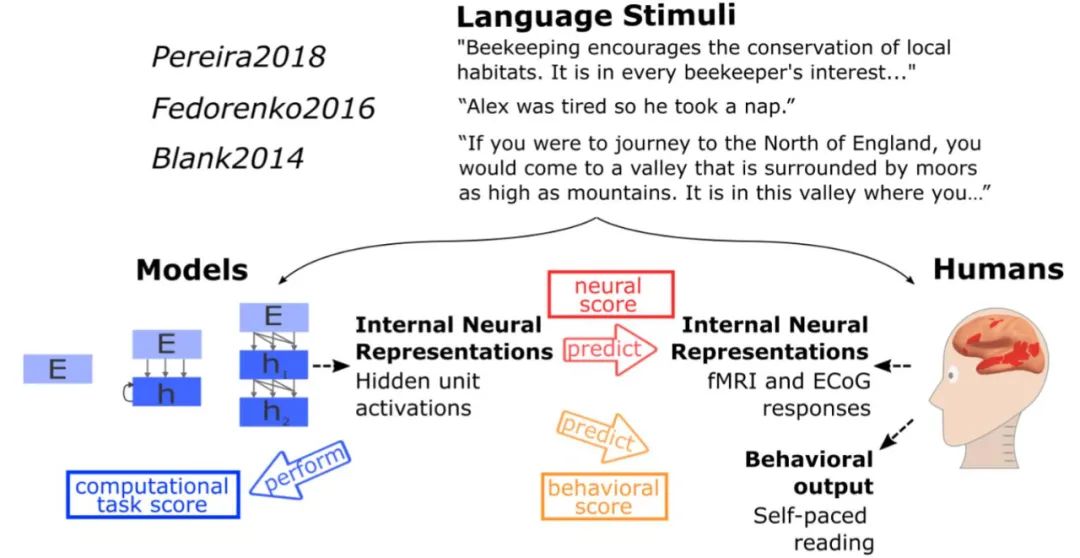

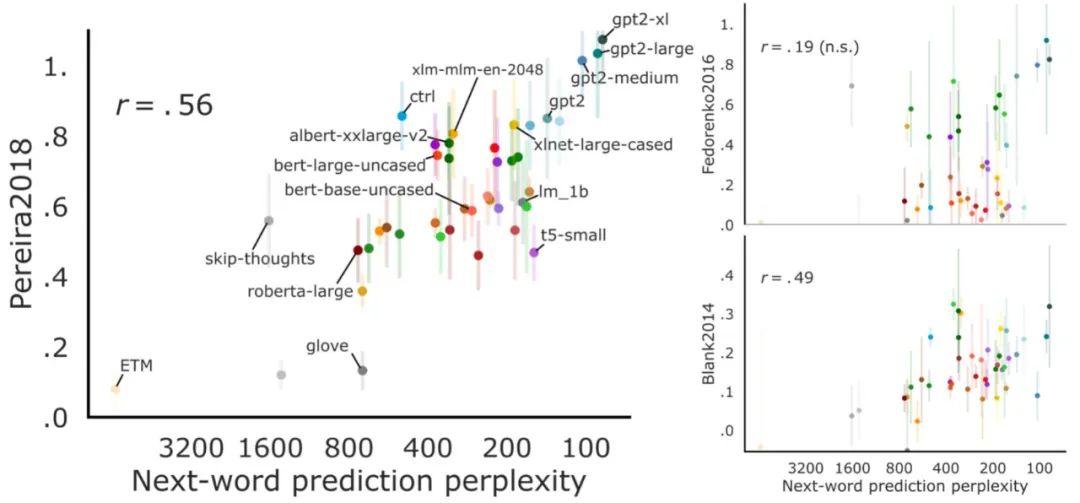

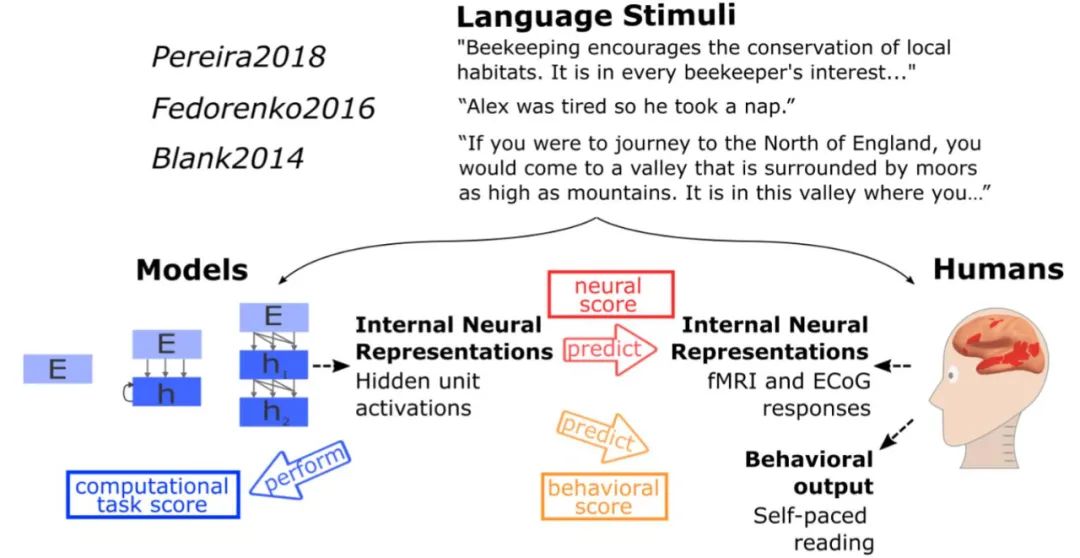

负责语言处理的人工神经网络模型与人类语言处理系统的比较。MIT 的研究者测试了不同模型对语言理解过程中的人类神经活动(fMRI and ECoG)和行为数据进行预测的效果。候选模型包括简单的嵌入模型、更复杂的循环模型和 transformer 网络。测试内容从句子到段落再到故事,这些内容要经历两个步骤:1)输入模型,2)呈现给人类参与者(视觉或听觉)。模型的内部表征主要在三个维度上进行评估:预测人类神经表征的能力;以阅读次数的形式预测人类行为的能力;执行计算任务的能力(例如下一个词预测)。研究者在许多个不同的模型中归纳分析了测试结果,得到的结论比从单个模型中得到的更具说服力。

每个模型都有一串词作为输入,研究人员测量了网络中节点的活动。然后,他们将这些模式与人脑中的活动进行了比较,并根据执行的三种语言任务进行度量:听故事、一次阅读一个句子,以及阅读每次只显示一个单词的句子。其中用到的人类数据集包括功能磁共振 (fMRI) 数据和在接受癫痫脑部手术的人中进行的颅内皮层电图测量数据。

他们发现,表现最佳的下一个单词预测模型的活动模式与人类大脑的活动模式非常相似。这些模型中的活动与人类行为度量高度相关,比如人们阅读文本的速度。

「我们发现,那些能够很好地预测神经反应的模型在预测人类行为反应时也往往表现良好。这两种情况都可以用模型在下一词预测中的表现来解释。这个三角形真的把一切都联系在了一起。」Schrimpf 表示。

「这项研究的一个关键结论是,语言处理是一个高度约束问题: AI 工程师创造的最佳解决方案最终与创造人类大脑进化过程所得到的解决方案类似。」斯坦福大学心理学和计算机科学助理教授 Daniel Yamins 评价说: 「人工智能网络并没有试图直接模仿大脑,然而最终看起来像大脑一样,这在某种意义上表明,人工智能和自然之间发生了某种趋同演化。」

图 6: 主要研究结果。红色与橙色框内是归一化后的神经及行为预测。

GPT-3 这种预测模型的关键计算特性是:它有一种被称为「前向单向预测 transformer」的成分。这种 transformer 架构能够根据之前的序列预测接下来会发生什么,它可以基于很长的前文内容进行预测(数百个单词),而不仅仅是最后几个单词。

科学家们还没有发现任何与这种信息处理相对应的大脑回路或学习机制,MIT 计算认知科学教授 Joshua Tenenbaum (本文作者之一)表示,然而新发现与先前提出的假设是一致的,即预测是语言处理的关键功能之一。

「语言处理的挑战之一是实时性,」他说,「语言输入了,你必须跟上,并且要实时理解它。」

研究人员打算建立这些语言处理模型的变体,观察它们架构中的微小变化是如何影响性能和适应人类神经数据能力的。

「对我来说,这个结果意义重大,」Fedorenko 说,「这完全改变了我的研究计划,因为我没有预料到,有生之年我能得到这些计算很明确的模型,捕捉到足够多的关于大脑的信息,从而利用它们来理解大脑是如何工作的。」

研究人员还计划将这些高效的语言模型与 Tenenbaum 实验室之前开发的一些计算机模型结合起来,这些模型可以执行其他类型的任务,比如构建物理世界的知觉表征。

「如果我们能够理解这些语言模型的作用,以及它们如何与那些更像是感知和思考的模型相联系,我们就可以得到更多关于事物如何在大脑中工作的综合模型。」

「这将带领我们走向更好的人工智能模型,同时也为我们提供了比过去更好的思路——关于大脑如何工作以及通用智能如何产生。」

https://cbmm.mit.edu/news-events/news/artificial-intelligence-sheds-light-how-brain-processes-language-mit-news

https://scitechdaily.com/surprisingly-smart-artificial-intelligence-sheds-light-on-how-the-brain-processes-language/

https://twitter.com/martin_schrimpf/status/1276832575022137344

与AI俱进,化时光为翎:「AI中国」机器之心2021年度评选暨特别策划

机器之心正式启动「AI中国」2021年度评选暨「与AI俱进,化时光为翎」特别策划,包括2021年度评选、年度内容专题、年度报告和AI科技年会四项内容。

我们希望借此与AI公司并肩,与创新产业同行,评选出企业榜、解决方案榜、 生态榜、行业事件榜和专业品牌榜,并与机器之心读者分享他们的技术突破与实践中的精彩行业故事。最终评选结果将在AI科技年会现场发布。

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com

个人中心

个人中心

我是园区

我是园区