近日,国际NLP领域顶级会议EMNLP 2021拉开帷幕。云从科技与上海交通大学联合研究团队的论文《Relation-aware Video Reading Comprehension for Temporal Language Grounding》成功被会议收录,并于大会进行线上宣讲。

EMNLP(Conference on Empirical Methods in Natural Language Processing)是计算语言学和自然语言处理领域的顶级国际会议之一,由国际语言学会 (ACL) 旗下 SIGDAT 组织。EMNLP 论文入选标准十分严格,今年论文录取率仅 23.3%,相比去年略有下降。EMNLP 学术会议上展示的研究成果,被认为代表着自然语言处理领域的前沿水平与未来发展方向。

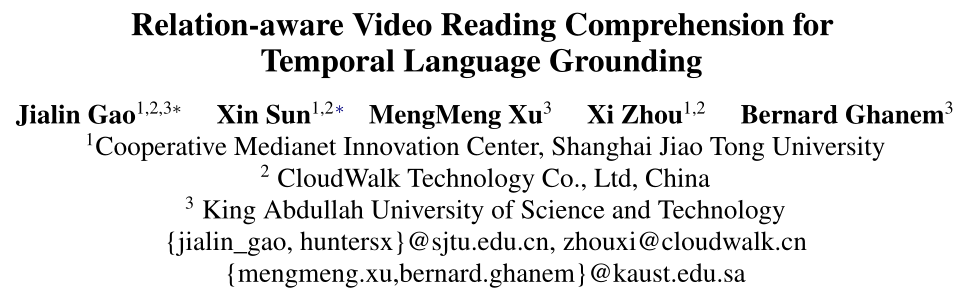

本次云从科技与上海交大联合团队的入选论文,围绕「基于语言查询的视频片段定位」这一视觉 - 文本的跨模态任务,将 NLP 与视觉技术结合,技术让机器同时具备「理解文字」和「看懂视频」的能力:

能够更精准地读懂文字,并理解视频内容,在整段视频中找出与给定文字相对应的视频片段。该项成果在多个数据集上都取得了优于过去研究的表现

。

这一成果在技术研究与实践领域都具有十分重要的意义:

在技术上让机器实现「多感官进化」:在云从看来,视觉、听觉等单点 AI 技术将越来越难以满足多样的应用需求。云从与上交大的该项技术,旨在让机器向完成 “跨模态任务” 进化:让机器能够同时掌握视觉、文字等多种模态的信息,做到像人类一样看懂、听懂、读懂,拥有全面的能力。近年来在学界,跨模态任务已成为一大研究热点,为 AI 领域注入新的活力;

突破单点技术,扩大跨模态应用场景:在实战场景中,随着高清摄像头的普及以及网络媒体的快速发展,各式各样的视频呈海量增长态势,自动化视频处理 AI 技术也迎来巨大需求。云从与上海交大的本项成果——基于语言查询的视频片段定位技术,能够有效解决治理、出行等多领域的难点问题,例如公共场合下的安全监控、社交媒体视频内容的审核等等,突破以往的单点技术应用瓶颈,带来数量级的效率提升。

今年以来云从的多项技术频频在国际权威数据集、顶级会议上收获佳绩:本次入选 EMNLP,也是云从今年在继视觉、语音等领先技术获得国际认可后,在 NLP 领域斩获的又一成果。NLP 等决策技术被认为是 AI 领域下一个技术突破口,使机器拥有理解、思考、分析决策的能力,为人机交互、行业应用等带来颠覆性改变。

在技术持续领先与创新的背后,是云从对于技术与产业变革的深刻理解。人工智能产业经历了单点技术的发展后,如今已来到云从定义的「二浪时代」,客户寻求以智能解决方案实现全业务链条的 AI 赋能,形成行业价值闭环。云从紧密把握产业趋势,突破了一般 AI 企业单点技术的局限,构筑起感知 - 认知 - 决策的核心技术闭环,凭借原创的核心技术,打造更全面的人机协同操作系统 CWOS 与行业智能化解决方案,加快各行业的智能化变革。

云从科技和上海交大提出了 Relation-aware Network(RaNet),探索视频片段定位任务中的多种层面关系。

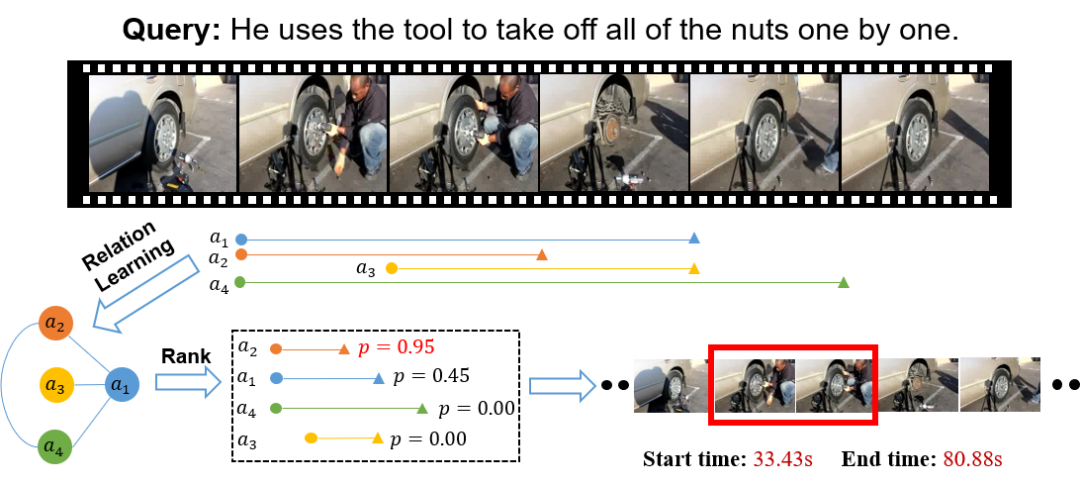

基于语言查询的视频片段定位任务(Temporal Language Grounding):给定一个视频和一段描述语句,通过融合视觉和语言两种模态的信息,在视频中定位出语言所描述内容的视频片段。

随着高清摄像头的普及以及网络媒体的快速发展,每天都会出现大量各式各样的视频,自动化的视频处理技术就被广泛应用在公共场合下的安全监控、社交媒体上视频内容的审核中,作为视觉 - 文本的跨模态任务,基于语言查询的视频片段定位也受到了越来越多的关注。

一方面,已有的视频片段定位方法通常只考虑了视频片段和整个句子的关系,而忽略了视频片段和句子中每个词语这种更加细致的关系,这样就不能全面地交互视觉和语言的信息。因此,云从和上交大联合团队的研究者们提出了一种 coarse-and-fine 的交互方式,从粗粒度和细粒度的角度同时考虑了视频片段 - 句子层面和关系以及视频片段 - 词语层面的关系。

另一方面,现有的工作往往忽视了不同视频片段之间的关系,或者仅仅采用了几层卷积网络的堆叠,存在计算量大、有噪声影响等缺点。本文的研究者们提出了一种稀疏连接的图网络,仅仅考虑了起始或者终止时间相同的视频片段,高效地建模了不同视频片段之间的关系,帮助模型更好地区分视觉上相似的视频片段。

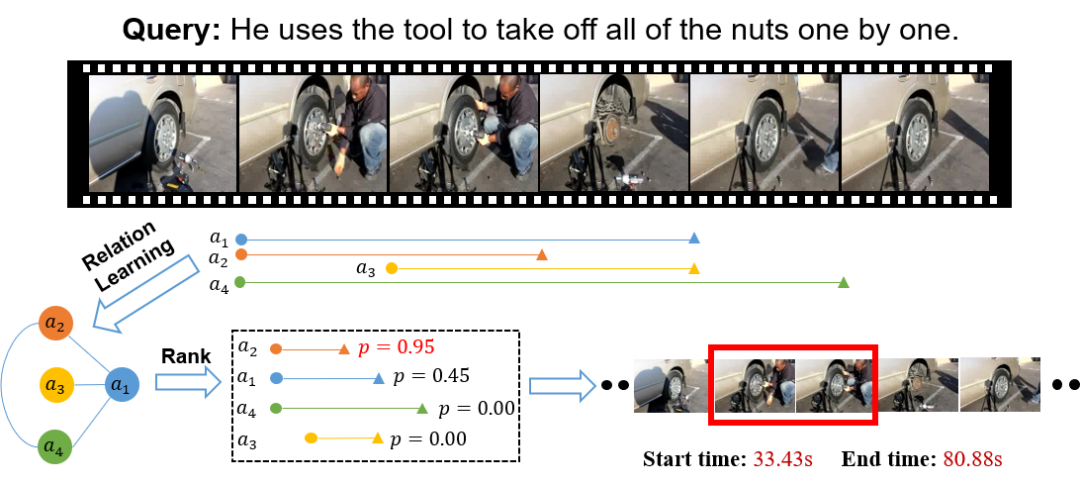

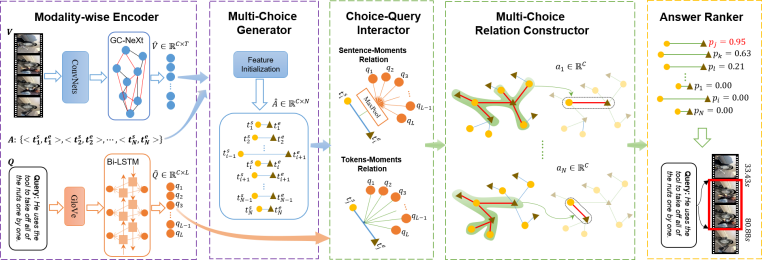

研究者们认为,基于语言查询的视频片段定位任务,在某种程度上和自然语言理解中的多项选择阅读理解任务(Multi-choice Reading Comprehension)类似,可以把给定的视频、查询语言和候选的视频片段分别类比为阅读理解中的文章、问题和候选答案。在将问题转化为阅读理解任务之后,研究者们提出了 RaNet 来解决该问题。如下为 RaNet 架构示意图:

多模态的特征编码模块;

候选视频片段的生成模块;

候选视频片段和查询语句的交互模块;

不同视频片段的关系构建模块;

结果选择模块。

特征编码模块中

,研究者采用了在时序动作检测(Temporal Action Localization)中表现优异的 GC-NeXt 来获取视频序列中的时序信息,使用双向的 LSTM 来获取语言信息的长时间依赖。

候选视频片段生成模块中

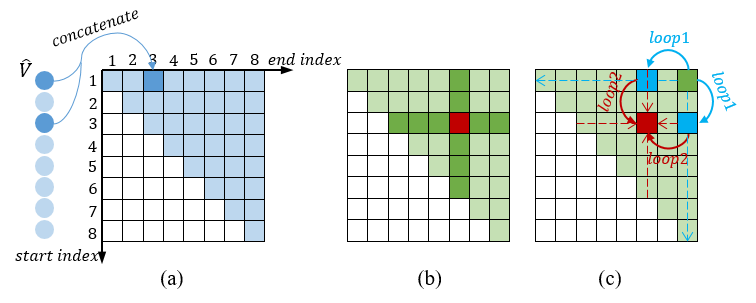

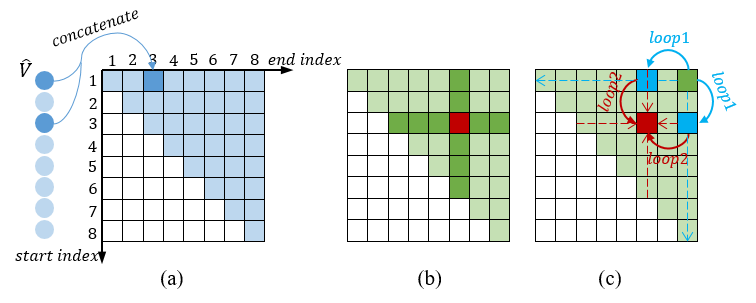

,研究者借鉴了之前工作 2D-TAN 的方式,构建了一个二维的时序网格图,每一个小网格都代表一个候选视频片段,其特征是由起始时间帧的特征和终止时间帧的特征串联而得。如下为候选生成器和特征初始化示意图:

视觉语言交互模块中

,研究者同时构建了视频片段 - 句子层面的关系和视频片段 - 单词层面的关系。对于视频片段和句子的关系,研究者首先对语言特征进行 max-pooling,然后和视频片段特征进行点乘。对于视频片段和单词的关系,研究者通过语言特征和视频片段特征首先构建出一个注意力权重矩阵,然后再与视频片段特征交互,动态地生成 query-aware 的视频片段表征。这种粗粒度和细粒度结合的方式能够充分地交互视觉和语言两种模态之间的信息。

视频片段关系构建模块中

,研究者将每个候选视频片段视作图的点,将这些视频片段之间的关系视作图的边,构建了视频片段关系的图网络模型。考虑到重叠比较高的视频片段关联性更强,研究者在构建图时仅考虑了和当前候选视频片段具有相同起始或者终止时间的视频片段,在网格图中就是一种十字架的形式。这样构建图的方式不仅可以减少不相关视频片段带来的噪声影响,还能有效提高模型的效率。

结果选择模块中

,研究者采用一个卷积层和 sigmoid 激活层为每个候选视频片段进行打分,根据得分从大到小排序,选择 top-1 或者 top-5 作为最终的预测视频片段。

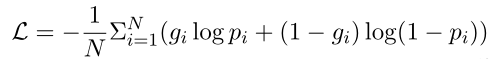

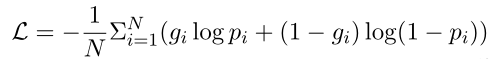

最后,研究者使用了 alignment loss 对模型进行了训练:

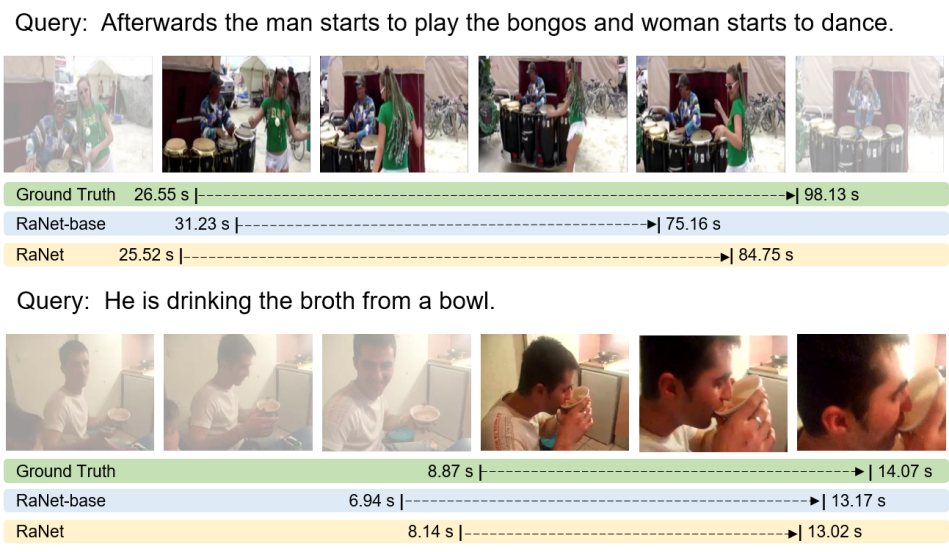

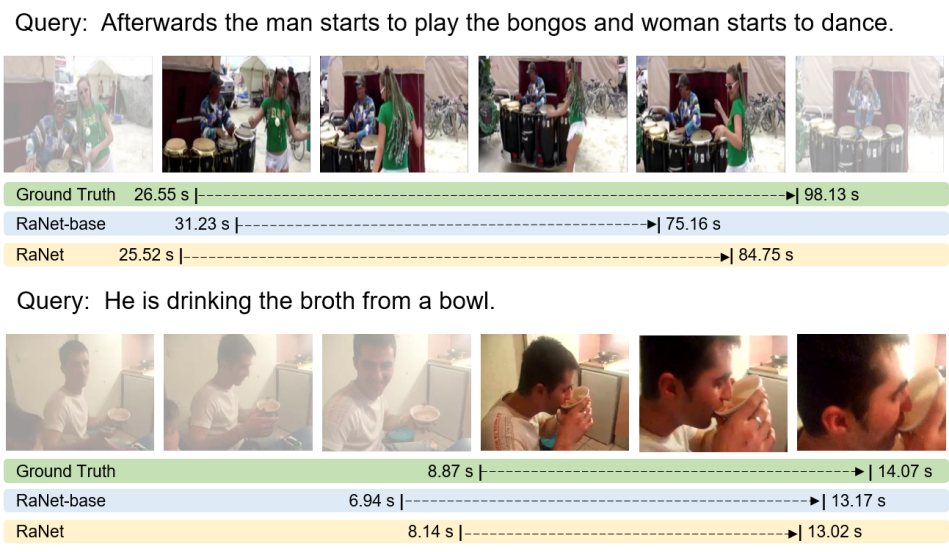

研究者通过大量的实验验证了 RaNet 对于基于语言查询的视频片段定位任务的有效性。

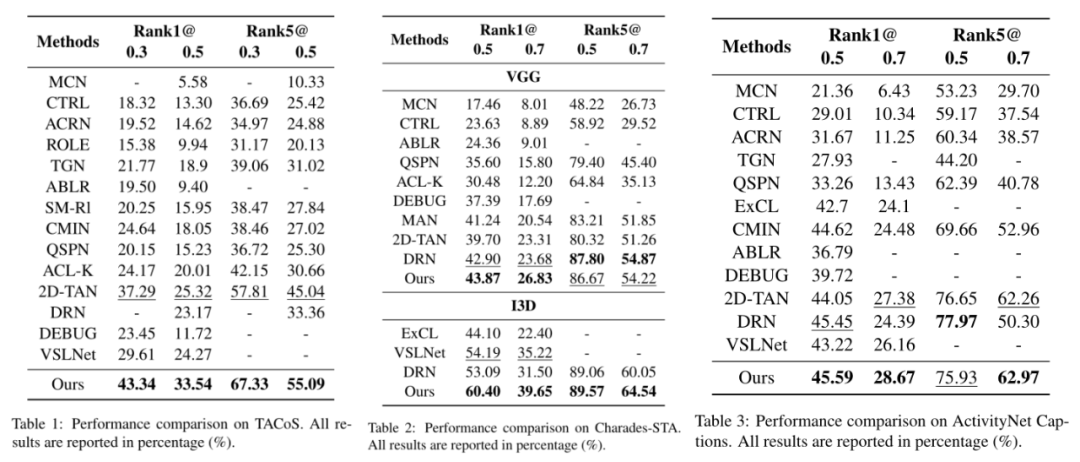

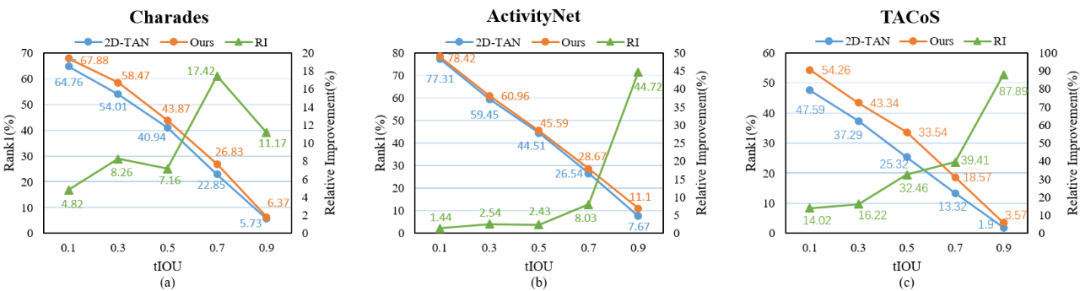

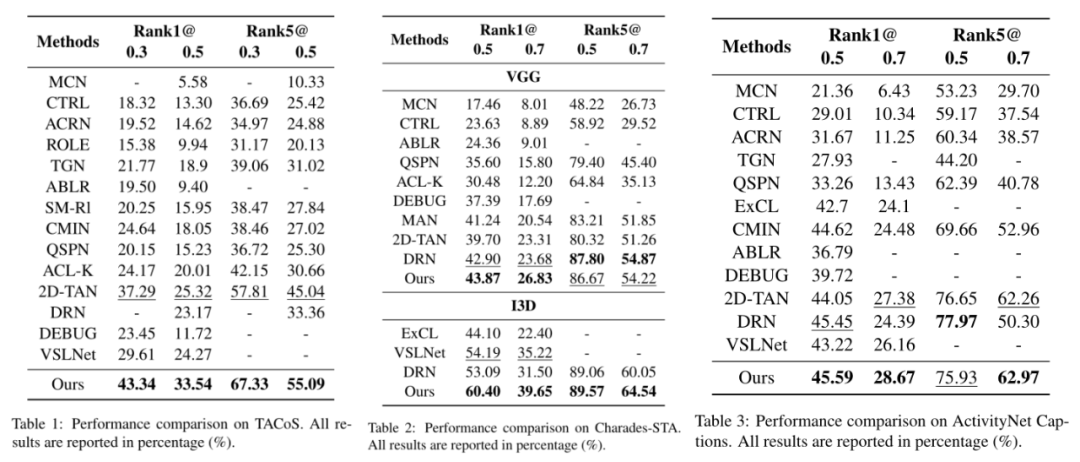

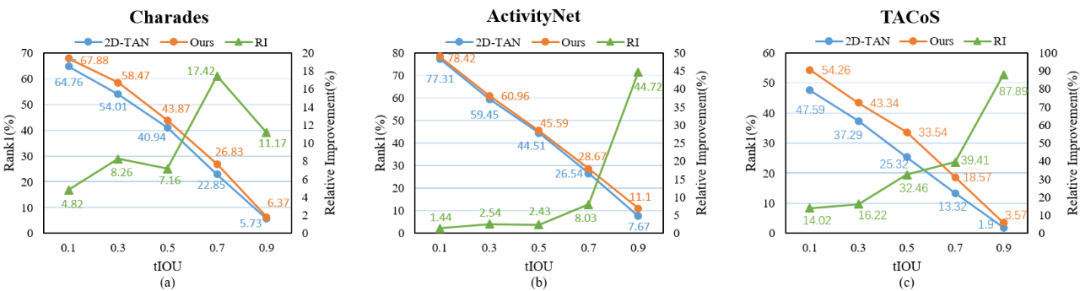

本文在 3 个常见数据集 TACoS、Charades-STA 和 ActivityNet Captions 上,采用了 Rank n@m 评价指标。与以往的工作进行了对比,RaNet 在 3 个数据集上基本都取得了 SOTA 的表现。

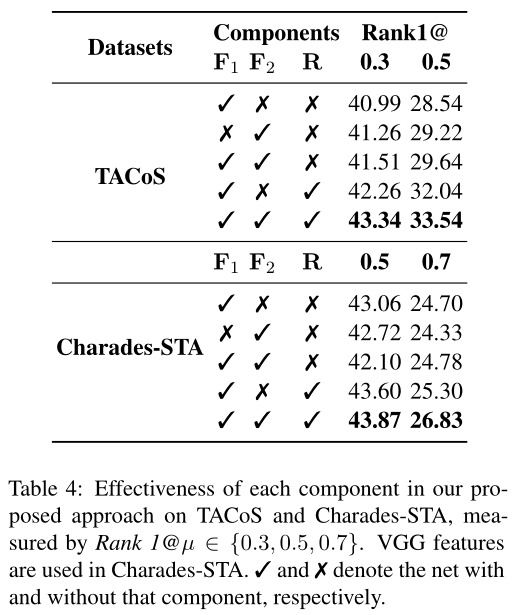

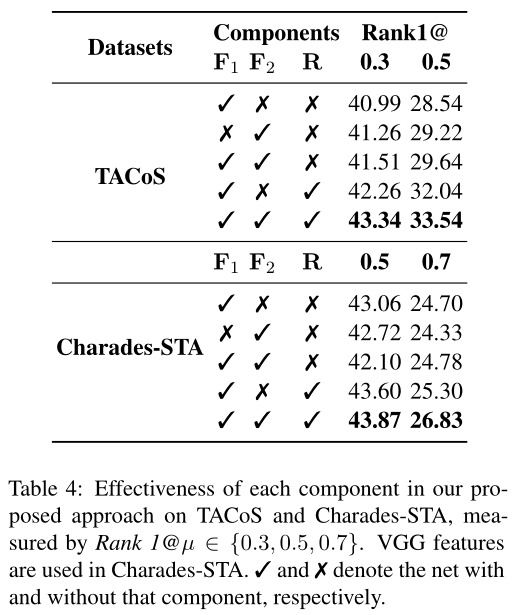

为了突显出模型中每个模块的重要性,研究者做了消融实验。从结果来看,同时考虑视频片段和句子的关系,以及视频片段和单词的关系,比单独考虑这两者带来的收益要多。当同时构建不同视频片段之间的关系时,模型能够更加精准地对视频片段进行定位。

研究者还与之前的 SOTA 模型 2D-TAN 比较了在不同 IoU 上的相对提升率,可以发现,在越高的 IoU 上,RaNet 提升得更加明显。

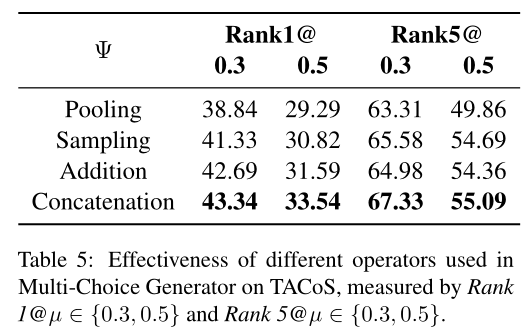

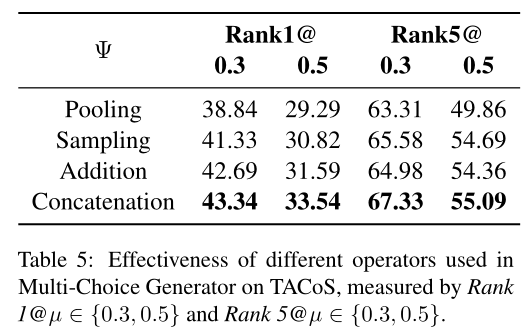

研究者比较了 Pooling、Sampling、Addition 和 Concatenation 这四种不同的视频片段特征的生成方式,结果发现更加关注边界特征的 Concatenation 操作表现更好。

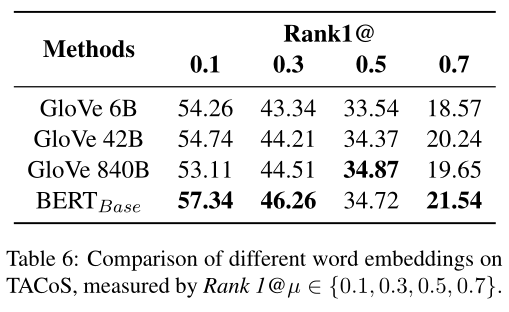

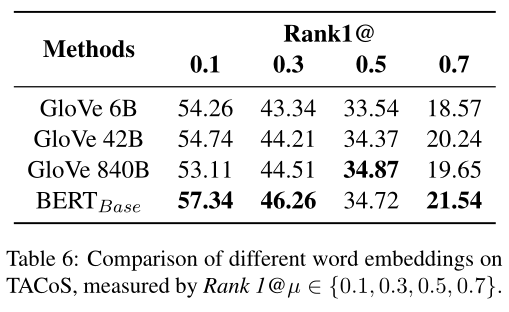

为了探寻不同的词向量编码对实验结果对的影响,研究者还比较了不同 word embeddings 的表现,发现越强的语言表征更有益于模型精准地定位视频片段。

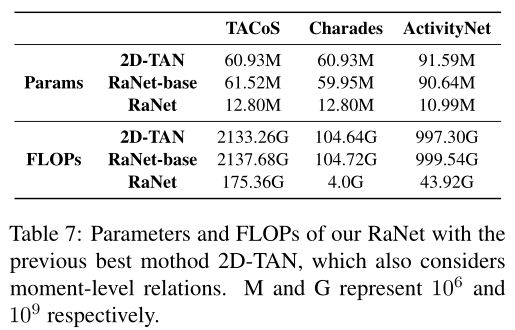

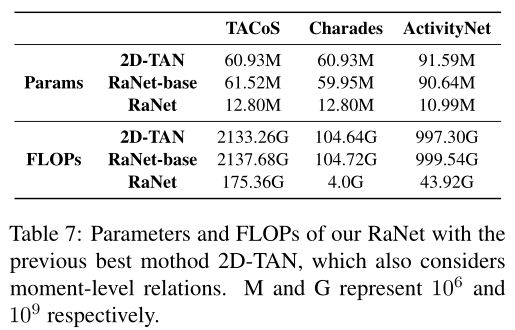

研究者还展示了模型在 TACoS 数据集上的参数量和 FLOPs,并和之前的 2D-TAN 模型进行了对比,由于在构建视频片段关系的模块中本文采用的是稀疏连接的图网络模型,所以参数量大大减小,效率得到了提升。

针对基于语言查询的视频片段定位这个任务,云从 - 上交大的联合研究团队提出了探索多层关系的 RaNet,将视频片段定位类比为自然语言处理中的多项选择阅读理解,同时建模了视频片段 - 句子层面和视频片段 - 单词层面的关系,并且提出了一种稀疏连接的图网络高效地建模了不同视频片段之间的关系,在公开数据集上取得了 SOTA 表现,更多技术细节请参考原论文。

[1] Songyang Zhang, Houwen Peng, Jianlong Fu, and Jiebo Luo. 2020b. Learning 2d temporal adjacent networks for moment localization with natural language. In Proceedings of the AAAI Conference on Artificial Intelligence, volume 34, pages 12870–12877.

[2] Mengmeng Xu, Chen Zhao, David S. Rojas, Ali Thabet, and Bernard Ghanem. 2020. G-tad: Sub-graph localization for temporal action detection. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).

[3] Zilong Huang, Xinggang Wang, Lichao Huang, Chang Huang, Yunchao Wei, and Wenyu Liu. 2019. Ccnet: Criss-cross attention for semantic segmentation. In

2019 IEEE/CVF International Conference on Computer Vision (ICCV), pages 603–612.

第一期:快速搭建基于Python和NVIDIA TAO Toolkit的深度学习训练环境

英伟达 AI 框架 TAO(Train, Adapt, and optimization)提供了一种更快、更简单的方法来加速培训,并快速创建高度精确、高性能、领域特定的人工智能模型。

11月15日19:30-21:00,英伟达专家带来线上分享,

将介绍:

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com

个人中心

个人中心

我是园区

我是园区